Перед тем как приступить к измерению информации, давайте введём определение и разберёмся, с чем имеем дело.

Определение

Информация — это сведения, сообщения, данные во всех своих проявлениях, формах независимо от их содержания. Даже полная белиберда, написанная на клочке бумаги может считаться информацией. Однако это определение из российского федерального закона.

Из международных стандартов можно выделить следующие значения:

- знания о предметах, фактах, идеях, значениях, мнениях, которыми обмениваются люди в конкретном контексте;

- знания о фактах, событиях, значениях, вещах, понятиях, которые в конкретном контексте имеют определённый смысл.

Данные — это материализованная форма представления информации, хотя в некоторых текстах эти два понятия могут быть использованы как синонимы.

Способы измерения

Понятие информации определяется по-разному. Измеряется она тоже по-разному. Можно выделить следующие основные подходы к измерению информации:

- Алфавитный подход.

- Вероятностный подход.

- Содержательный подход к измерению информации.

Все они соответствуют различным определениям и имеют различных авторов, мнение которых касательно данных различалось. Вероятностный подход был создан А.Н. Колмогоровым и не учитывал субъект передачи информации, то есть он измеряет ее количество независимо от того, насколько она важна для передающего и принимающего её субъекта. Содержательный подход к измерению информации, созданный К. Шенноном, учитывает больше переменных и является своего рода оценкой важности этих данных для принимающей стороны. Но давайте рассмотрим всё по порядку.

Вероятностный подход

Как было уже сказано, подходы к измерению количества информации очень различаются. Этот подход был разработан Шенноном в 1948 году. Он заключается в том, что количество информации зависит от количества событий и их вероятности. Вычислить количество полученных сведений при этом подходе можно по нижеследующей формуле, в которой I — это искомое количество, N — число событий и pi — это вероятность каждого конкретного события.

Абсолютно самодостаточный метод вычисления количества информации. Он не учитывает, что именно написано в сообщении, и не связывает количество написанного с содержанием. Для вычисления количества информации нам необходимо знать мощность алфавита и объём текста. По сути, мощность алфавита не ограничена. Однако в компьютерах используется достаточный алфавит мощностью в 256 символов. Таким образом мы можем посчитать, сколько информации несёт в себе один символ печатного текста на компьютере. Поскольку 256=2 8 , то один символ составляет 8 бит данных.

1 бит — это минимальное, неделимое количество информации. По Шеннону, это такое количество данных, которое снижает неопределённость знаний в два раза.

1024 байта = 1 килобайт.

1024 килобайта = 1 мегабайт.

Как видите, подходы к измерению информации очень различаются. Существует еще один способ измерить ее количество. Он позволяет оценить не только количество, но и качество. Содержательный подход к измерению информации позволяет учесть полезность данных. Также этот подход означает, что количество сведений, заключенных в сообщении, определено количеством новых знаний, которые получит человек.

Если выражаться математическими формулами, то количество сведений, равное 1биту, должно уменьшать неопределённость знаний человека в 2 раза. Таким образом, воспользуемся следующей формулой для определения количества информации:

Х=log2Н , где Х — количество получаемых данных, а Н — количество равновероятных исходов. Для примера решим задачку.

Пусть у нас есть трёхгранная пирамидка с четырьмя сторонами. При подбрасывании её вверх есть шанс, что она упадёт на одну из четырёх сторон. Таким образом, Н=4 (количество равновероятностных исходов). Как вы понимаете, шанс, что наш объект упадёт на одну из граней и так останется стоять, меньше, чем если подбрасывать монету и ожидать, что она встанет ребром.

Как видите, результат 2. Но что это за цифра? Как было уже сказано, минимальная неделимая единица измерения — бит. В итоге, после падения мы получили 2 бита информации.

Подходы к измерению информации используют логарифмы для вычислений. Для упрощения этих действий можете воспользоваться калькулятором либо специальной таблицей логарифмов.

Где вам могут пригодиться знания, полученные в этой статье, особенно данные про содержательный подход к измерению информации? Без сомнения, на экзамене по информатике. Рассмотренный вопрос позволяет лучше ориентироваться в компьютерных технологиях, в частности, в размерах внутренней и внешней памяти. На деле эти знания практической ценности не имеют, разве что в науке. Ни один работодатель не заставит вас вычислять количество информации в напечатанном документе или написанной программе. Разве что в программировании, где вам будет необходимо задать размер памяти, выделяемой под переменную.

Измерение информации

Содержательный подход

С позиции содержательного подхода к измерению информации решается вопрос о количестве информации в сообщении, получаемом человеком. Рассматривается следующая ситуация:

1) человек получает сообщение о некотором событии; при этом заранее известна неопределенность знания человека об ожидаемом событии. Неопределенность знания может быть выражена либо числом возможных вариантов события, либо вероятностью ожидаемых вариантов события;

2) в результате получения сообщения неопределенность знания снимается: из некоторого возможного количества вариантов оказался выбранным один;

3) по формуле вычисляется количество информации в полученном сообщении, выраженное в битах.

Формула, используемая для вычисления количества информации, зависит от ситуаций, которых может быть две:

1. Все возможные варианты события равновероятны. Их число конечно и равно N.

2. Вероятности (p) возможных вариантов события разные и они заранее известны:

i>, i = 1..N. Здесь по-прежнему N — число возможных вариантов события.

Равновероятные события. Если обозначить буквой i количество информации в сообщении о том, что произошло одно из N равновероятных событий, то величины i и N связаны между собой формулой Хартли:

Величина i измеряется в битах. Отсюда следует вывод:

1 бит — это количество информации в сообщении об одном из двух равновероятных событий.

Формула Хартли — это показательное уравнение. Если i — неизвестная величина, то решением уравнения (1) будет:

Формулы (1) и (2) тождественны друг другу. Иногда в литературе формулой Хартли называют (2).

Пример 1. Сколько информации содержит сообщение о том, что из колоды карт достали даму пик?

В колоде 32 карты. В перемешанной колоде выпадение любой карты — равновероятные события. Если i — количество информации в сообщении о том, что выпала конкретная карта (например, дама пик), то из уравнения Хартли:

Отсюда: i = 5 бит.

Пример 2. Сколько информации содержит сообщение о выпадении грани с числом 3 на шестигранном игральном кубике?

Считая выпадение любой грани событием равновероятным, запишем формулу Хартли: 2 i = 6. Отсюда: i = log26 = 2,58496 бит.

Неравновероятные события (вероятностный подход)

Если вероятность некоторого события равна p, а i (бит) — это количество информации в сообщении о том, что произошло это событие, то данные величины связаны между собой формулой:

Решая показательное уравнение (3) относительно i, получаем:

Формула (4) была предложена К.Шенноном, поэтому ее называют формулой Шеннона.

Методические рекомендации

Обсуждение связи между количеством информации в сообщении и его содержанием может происходить на разных уровнях глубины.

Качественный подход

Качественный подход, который может использоваться на уровне пропедевтики базового курса информатики (5–7-е классы) или в базовом курсе (8–9-е классы).

На данном уровне изучения обсуждается следующая цепочка понятий: информация — сообщение — информативность сообщения.

Исходная посылка: информация — это знания людей, получаемые ими из различных сообщений. Следующий вопрос: что такое сообщение? Сообщение — это информационный поток (поток данных), который в процессе передачи информации поступает к принимающему его субъекту. Сообщение — это и речь, которую мы слушаем (радиосообщение, объяснение учителя), и воспринимаемые нами зрительные образы (фильм по телевизору, сигнал светофора), и текст книги, которую мы читаем, и т.д.

Вопрос об информативности сообщения следует обсуждать на примерах, предлагаемых учителем и учениками. Правило: информативным назовем сообщение, которое пополняет знания человека, т.е. несет для него информацию. Для разных людей одно и то же сообщение с точки зрения его информативности может быть разным. Если сведения “старые”, т.е. человек это уже знает, или содержание сообщения непонятно человеку, то для него это сообщение неинформативно. Информативно то сообщение, которое содержит новые и понятные сведения.

Примеры неинформативных сообщений для ученика 8-го класса:

1)“Столица Франции — Париж” (не новое);

2) “Коллоидная химия изучает дисперсионные состояния систем, обладающих высокой степенью раздробленности” (не понятное).

Пример информативного сообщения (для тех, кто этого не знал): “Эйфелева башня имеет высоту 300 метров и вес 9000 тонн”.

Введение понятия “информативность сообщения” является первым подходом к изучению вопроса об измерении информации в рамках содержательной концепции. Если сообщение неинформативно для человека, то количество информации в нем, с точки зрения этого человека, равно нулю. Количество информации в информативном сообщении больше нуля.

Количественный подход в приближении равновероятности

Данный подход может изучаться либо в углубленном варианте базового курса в основной школе, либо при изучении информатики в 10–11-х классах на базовом уровне.

Рассматривается следующая цепочка понятий: равновероятные события — неопределенность знаний — бит как единица измерения информации — формула Хартли — решение показательного уравнения для N равного целым степеням двойки.

Раскрывая понятие равновероятности, следует отталкиваться от интуитивного представления детей, подкрепив его примерами. События равновероятны, если ни одно из них не имеет преимущества перед другими.

Введя частное определение бита, которое было дано выше, затем его следует обобщить:

Сообщение, уменьшающее неопределенность знаний в 2 раза, несет 1 бит информации.

Это определение подкрепляется примерами сообщений об одном событии из четырех (2 бита), из восьми (3 бита) и т.д.

На данном уровне можно не обсуждать варианты значений N, не равные целым степеням двойки, чтобы не сталкиваться с проблемой вычисления логарифмов, которые в курсе математики пока не изучались. Если же у детей будут возникать вопросы, например: “Сколько информации несет сообщение о результате бросания шестигранного кубика”, — то объяснение можно построить следующим образом. Из уравнения Хартли: 2 i = 6. Поскольку 2 2 3 , следовательно, 2 i = 1/1 = 1. Отсюда, i = 0 бит.

Формула Хартли (1) является частным случаем формулы (3). Если имеется N равновероятных событий (результат бросания монеты, игрального кубика и т.п.), то вероятность каждого возможного варианта равна p = 1/N. Подставив в (3), снова получим формулу Хартли: 2 i = N. Если бы в примере 3 автобусы № 5 и № 7 приходили бы к остановке из 100 раз каждый по 50, то вероятность появления каждого из них была бы равна 1/2. Следовательно, количество информации в сообщении о приходе каждого автобуса равно i = log22 = 1 биту. Пришли к известному варианту информативности сообщения об одном из двух равновероятных событий.

Пример 4. Рассмотрим другой вариант задачи об автобусах. На остановке останавливаются автобусы № 5 и № 7. Сообщение о том, что к остановке подошел автобус № 5, несет 4 бита информации. Вероятность появления на остановке автобуса с № 7 в два раза меньше, чем вероятность появления автобуса № 5. Сколько бит информации несет сообщение о появлении на остановке автобуса № 7?

Запишем условие задачи в следующем виде:

Вспомним связь между вероятностью и количеством информации: 2 i = 1/p

Подставляя в равенство из условия задачи, получим:

Из полученного результата следует вывод: уменьшение вероятности события в 2 раза увеличивает информативность сообщения о нем на 1 бит. Очевидно и обратное правило: увеличение вероятности события в 2 раза уменьшает информативность сообщения о нем на 1 бит. Зная эти правила, предыдущую задачу можно было решить “в уме”.

С точки зрения содержательного подхода информация

Вопрос: «Как измерить информацию?» очень непростой. Ответ на него зависит от того, что понимать под информацией. Но поскольку определять информацию можно по-разному, то и способы измерения тоже могут быть разными.

Содержательный подход к измерению информации.

Для человека информация — это знания человека. Рассмотрим вопрос с этой точки зрения.

Получение новой информации приводит к расширению знаний. Если некоторое сообщение приводит к уменьшению неопределенности нашего знания, то можно говорить, что такое сообщение содержит информацию.

Отсюда следует вывод, что сообщение информативно (т.е. содержит ненулевую информацию), если оно пополняет знания человека. Например, прогноз погоды на завтра — информативное сообщение, а сообщение о вчерашней погоде неинформативно, т.к. нам это уже известно.

Нетрудно понять, что информативность одного и того же сообщения может быть разной для разных людей. Например: «2×2=4» информативно для первоклассника, изучающего таблицу умножения, и неинформативно для старшеклассника.

Но для того чтобы сообщение было информативно оно должно еще быть понятно. Быть понятным, значит быть логически связанным с предыдущими знаниями человека. Определение «значение определенного интеграла равно разности значений первообразной подынтегральной функции на верхнем и на нижнем пределах», скорее всего, не пополнит знания и старшеклассника, т.к. оно ему не понятно. Для того, чтобы понять данное определение, нужно закончить изучение элементарной математики и знать начала высшей.

Получение всяких знаний должно идти от простого к сложному. И тогда каждое новое сообщение будет в то же время понятным, а значит, будет нести информацию для человека.

Сообщение несет информацию для человека, если содержащиеся в нем сведения являются для него новыми и понятными.

Очевидно, различать лишь две ситуации: «нет информации» — «есть информация» для измерения информации недостаточно. Нужна единица измерения, тогда мы сможем определять, в каком сообщении информации больше, в каком — меньше.

Единица измерения информации была определена в науке, которая называется теорией информации. Эта единица носит название «бит». Ее определение звучит так:

Например, после сдачи зачета или выполнения контрольной работы ученик мучается неопределенностью, он не знает, какую оценку получил. Наконец, учитель объявляет результаты, и он получаете одно из двух информационных сообщений: «зачет» или «незачет», а после контрольной работы одно из четырех информационных сообщений: «2», «3», «4» или «5».

Информационное сообщение об оценке за зачет приводит к уменьшению неопределенности знания в два раза, так как получено одно из двух возможных информационных сообщений. Информационное сообщение об оценке за контрольную работу приводит к уменьшению неопределенности знания в четыре раза, так как получено одно из четырех возможных информационных сообщений.

Рассмотрим еще один пример.

На книжном стеллаже восемь полок. Книга может быть поставлена на любую из них. Сколько информации содержит сообщение о том, где находится книга?

Применим метод половинного деления. Зададим несколько вопросов уменьшающих неопределенность знаний в два раза.

Задаем вопросы:

— Книга лежит выше четвертой полки?

— Нет.

— Книга лежит ниже третьей полки?

— Да .

— Книга — на второй полке?

— Нет.

— Ну теперь все ясно! Книга лежит на первой полке!

Каждый ответ уменьшал неопределенность в два раза.

Всего было задано три вопроса. Значит набрано 3 бита информации. И если бы сразу было сказано, что книга лежит на первой полке, то этим сообщением были бы переданы те же 3 бита информации.

Если обозначить возможное количество событий, или, другими словами, неопределенность знаний N, а буквой I количество информации в сообщении о том, что произошло одно из N событий, то можно записать формулу:

Количество информации, содержащееся в сообщении о том, что произошло одно из N равновероятных событий, определяется из решения показательного уравнения: 2 I = N.

Пример: Вы бросаете монету, загадывая, что выпадет: орел или решка?

Решение: Есть два варианта возможного результата бросания монеты. Ни один из этих вариантов не имеет преимущества перед другим (равновероятны). Перед подбрасыванием монеты неопределенность знаний о результате равна двум.

После совершения действия неопределенность уменьшилась в 2 раза. Получили 1 бит информации.

Ответ: Результат подбрасывания монеты принес 1 бит информации.

Содержательный подход к оценке количества информации

В зависимости от задачи, которую перед собой ставит человек, можно использовать разные способы представления информации. Для того чтобы послушать музыку, нет необходимости переводить её в нотную запись. А вот чтобы научиться её играть, лучше воспользоваться нотами, чем подбирать мелодию на слух. Формализованные языки используются для кодирования информации. Определенный набор символов алфавита образует слово, а число этих символов – это его длина. При изменении длины слова будет меняться и информация, заключенная в нем. Чтобы разобраться в изменениях информации, необходима ее оценка, т.е. измерение количества.

Подходы к оценке количества информации

Как понять, какое количество информации получил человек в том или ином сообщении?

Разные люди, получившие одинаковые сообщения, по-разному оценивают количество информации, содержащейся в них. Это происходит потому, что знания людей в вопросах, о которых идет речь в сообщениях, до их получения были различными. Таким образом те, у кого знания в рассматриваемом вопросе были не значительны, сочтут, что получили много полезной информации, те же, кто знал больше, могут отметить, что информации не получили вовсе. Отсюда напрашивается вывод, что количество информации в сообщении зависит от того, насколько новым содержание этого сообщения будет для получателя.

Попробуй обратиться за помощью к преподавателям

В таком случае, количество информации в одном и том же сообщении должно определяться отдельно для каждого получателя, то есть иметь субъективный характер. При этом нельзя объективно оценить количество информации, содержащейся даже в простом сообщении. Поэтому, когда информация рассматривается как новизна сообщения для получателя (бытовой подход), не ставится вопрос об измерении ее количества. Задача измерения информации не так проста, как кажется на первый взгляд. Различные подходы к измерению информации обусловлены различными подходами к её определению и кодированию:

- Субъективное восприятие сообщения (содержало ли оно новую для вас информацию или нет, насколько эта информация была полезной) делает невозможным его количественную оценку при обыденном подходе к понятию «информация».

- Подход к информации как мере уменьшения неопределённости знания позволяет применять вероятностный подход к её измерению.

- Подход, основанный на подсчёте числа символов в сообщении (количества данных), называется алфавитным.

Задай вопрос специалистам и получи

ответ уже через 15 минут!

Содержательный подход к оценке количества информации

Рассмотрим более подробно первый подход к измерению количества информации, его называют содержательным.

Для человека информация — это его знания об окружающей его действительности. Получение человеком новой информации приводит к расширению этих знаний. Если некое сообщение приводит к уменьшению неопределенности знания в каком-либо вопросе, то можно с уверенностью сказать, что это сообщение содержит информацию.

Таким образом, можно утверждать, что сообщение информативно (т.е. содержит ненулевую информацию), если оно пополняет знания человека. Например, программа телепередач на завтра — информативное сообщение, а сообщение о вчерашних телепрограммах неинформативно, т.к. нам это уже известно.

С точки зрения содержательного подхода, сообщение об уже известном для человека событии не содержит информации. Например, сообщение учителя на уроке информатики: «Сейчас вы будете изучать информатику» не содержит информации для школьников, на каком уроке они находятся. Сообщение содержит информацию в том случае, когда из некоторых возможных, так как такое уменьшает неопределенность знания. Например, урок информатики может проводиться как в обычном, так и в компьютерном кабинете. В этом случае сообщение «Урок информатики будет проведен в компьютерном кабинете» содержит информацию для учащихся, поскольку они получили новое знание о месте проведения урока информатики.

Нетрудно понять, что информативность одних и тех же сообщений может быть различной для разных людей. Например, азы грамматики информативны для первоклассника, который только начинает учиться писать, и совсем неинформативны для старшеклассников.

Однако для того, чтобы сообщение было информативным, оно должно быть, как минимум, понятным. А значит быть логически связанным с предыдущими знаниями человека в этом вопросе. Так, например, программа низкого уровня, написанная на машинном языке, вероятнее всего не пополнит знаний старшеклассника, так как будет ему не понятна, поскольку он, в свою очередь, изучает на информатике один из языков программирования высокого уровня, как более простой, а ему предлагают знания из области специальных.

Получение всяких знаний должно идти поэтапно: от простого к сложному. Только в этом случае каждое новое сообщение будет понятным, а значит информативным.

Единица измерения количества информации

Очевидно, если различать только $2$ ситуации: когда нет информации, или есть информация, то для измерения ее количества этого будет не достаточно. Необходимо определиться с единицей измерения, и тогда возможной станет оценка количества информации, в каком сообщении – ее больше, в каком — меньше.

Такая единица измерения информации существует, она была определена в науке, которая называется теорией информации. Эта единица носит название «бит».

Один бит информации – это сообщение, уменьшающее неопределенность знаний в два раза.

Например, после сдачи зачета или экзамена студент страдает от неопределенности, поскольку ему не известна оценка, которую он получил. После объявления преподавателем результатов он получает $1$ из $2$ информационных сообщений: «зачет» или «незачет», а после экзамена $1$ из $4$ информационных сообщений: $«2»$, $«3»$, $«4»$ или $«5»$.

Первое информационное сообщение приводит к уменьшению неопределенности знания в $2$ раза, так как получено $1$ из $2$ возможных информационных сообщений. Второе сообщение об оценке за экзамен приводит к уменьшению неопределенности знания в $4$ раза, так как получено $1$ из $4$ возможных информационных сообщений.

Неопределенность знаний о некотором событии — это количество возможных результатов события.

Рассмотрим еще один пример.

На стене в подъезде восемь почтовых ящиков. Письмо может находиться в любом из них. Сколько информации содержит сообщение о том, где находится письмо?

Применим метод половинного деления. Зададим несколько вопросов уменьшающих неопределенность знаний в два раза. Задаем вопросы:

— Письмо находится правее четвертого ящика?

— Письмо находится левее третьего ящика?

— Письмо — во втором ящике?

— Ответ ясен! Письмо находится в первом ящике!

Каждый ответ уменьшал неопределенность в $2$ раза.

Всего было задано $3$ вопроса. Соответственно набрано $3$ бита информации. И если бы сразу было сказано, что письмо находится в первом ящике, то этим сообщением были бы переданы те же $3$ бита информации.

Так и не нашли ответ

на свой вопрос?

Просто напиши с чем тебе

нужна помощь

Содержательный подход к измерению информации

Другое название содержательного подхода – вероятностный. Вероятность — степень возможности появления какого-либо определенного события в тех или иных условиях. Два события называются равновероятными (или равновозможными), если нет никаких объективных причин считать, что одно из них может наступить чаще, чем другое.

Американский инженер Р. Хартли в 1928 г. процесс получения информации рассматривал как выбор одного сообщения из конечного наперёд заданного множества из N равновероятных сообщений, а количество информации I, содержащееся в выбранном сообщении, определял как двоичный логарифм N.

Рассмотрим в качестве примера опыт, связанный с бросанием правильной игральной кости, имеющей N граней. Результаты данного опыта могут быть следующие: выпадение грани с одним из следующих знаков: 1, 2, . . . N.

Введем в рассмотрение численную величину, измеряющую неопределенность — энтропию (обозначим ее H). Согласно развитой теории, в случае равновероятного выпадания каждой из граней величины N и H связаны между собой формулой Хартли H = log2N.

Важным при введении какой-либо величины является вопрос о том, что принимать за единицу ее измерения. Очевидно, H будет равно единице при N = 2. Иначе говоря, в качестве единицы принимается количество информации, связанное с проведением опыта, состоящего в получении одного из двух равновероятных исходов (примером такого опыта может служить бросание монеты при котором возможны два исхода: «орел», «решка»). Такая единица количества информации и является «битом».

Приведем примеры равновероятных сообщений: при бросании монеты: «выпала решка», «выпал орел»; на странице книги: «количество букв чётное», «количество букв нечётное».

Определим теперь, являются ли равновероятными сообщения «первой выйдет из дверей здания женщина» и «первым выйдет из дверей здания мужчина». Однозначно ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, например, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины.

Для задач такого рода американский учёный Клод Шеннон предложил в 1948 г. другую формулу определения количества информации, учитывающую возможную неодинаковую вероятность сообщений в наборе.

где pi — вероятность того, что именно i-е сообщение выделено в наборе из N сообщений.

Вероятность события А определяется формулой:

где m — число элементарных исходов, благоприятствующих А;

n — число всех возможных элементарных исходов испытания.

Легко заметить, что если вероятности p1, . pNравны, то каждая из них равна 1 / N, и формула Шеннона превращается в формулу Хартли.

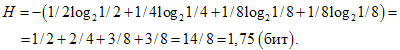

Рассмотрим следующий пример. Пусть при бросании несимметричной четырехгранной пирамидки вероятности выпадения граней будут следующими: p1=1/2, p2=1/4, p3=1/8, p4=1/8, тогда количество информации, получаемое после броска, можно рассчитать по формуле:

Для симметричной четырехгранной пирамидки количество информации будет: H=log24=2(бит).

Заметим, что для симметричной пирамидки количество информации оказалось больше, чем для несимметричной пирамидки. Максимальное значение количества информации достигается для равновероятных событий.

1. Какое количество информации несет в себе сообщение о том, что нужная вам программа находится на одной из восьми дискет?

N=8 – количество дискет (число событий)

2. Какое количество информации получит второй игрок при игре в крестики-нолики на поле 8х8 после первого хода первого игрока, играющего крестиками?

N=64 – количество полей

3. Сообщение о том, что ваш друг живет на десятом этаже несет в себе 4 бита информации. Сколько этажей в доме?

4. В коробке 5 синих и 15 красных шариков. Какое количество информации несет сообщение, что из коробки достали синий шарик?

N=15+5=20 всего шариков

K=5 – синих (его достали)

5. Какое количество информации о цвете вынутого шарика будет получено, если в непрозрачном пакете хранятся: 10 белых, 20 красных, 30 синих и 40 зеленых шариков?

K=10+20+30+40=100 – общее количество шариков

6. Студенты группы изучают один из трех языков: английский, немецкий или французский. Причем 12 студентов не учат английский. Сообщение, что случайно выбранный студент Петров изучает английский, несет log23 бит информации, а что Иванов изучает французский – 1 бит. Сколько студентов изучают немецкий язык?

Y– учат французский

X– учат английский, 12 не учат английский. Всего 12+Xстудентов

Содержательный подход к измерению информации

за привлеченного слушателя на курсы профессиональной переподготовки

Выбранный для просмотра документ Конспект — Содержательный подход к измер. инф.docx

УРОК НА ТЕМУ

«СОДЕРЖАТЕЛЬНЫЙ ПОДХОД К ИЗМЕРЕНИЮ ИНФОРМАЦИИ»

Тема урока: Содержательный подход к измерению информации (теория информации Шеннона).

Цель урока: приобретение обучающимися теоретических знаний и практических навыков по измерению количество информации с точки зрения содержательного подхода.

1. Актуализация опорных знаний

Проводится фронтальный опрос, вопросы по одному выводятся на экран (см. презентацию), ответы учащихся тезисно записываются на доске.

Учитель. Ребята, давайте сегодня поговорим об измерении информации. Но сначала вспомним, что вы уже знаете о науке информатике.

· Что изучает информатика? (Проблемы обработки, хранения и передачи информации.)

· Что является предметом изучения информатики? (Информация.)

· Что мы уже знаем об информации и что умеем делать с информацией? (Знаем, что такое информация, виды информации, свойства информации; умеем кодировать информацию, измерять информацию.)

· Какую информацию мы умеем измерять? (Текстовую, графическую.)

· В каких единицах измеряется информация? (Бит, байт, килобит, килобайт и т. д.)

· Что означают эти единицы измерения? (Бит — один двоичный знак, 1 байт = 8 бит; сигнал ЭВМ: есть — 1, нет — 0.)

· От чего зависит количество информации? (Количество текстовой информации зависит от количества символов, графической — от количества точек и количества цветов.)

Разминка на измерение информации.

На доске записаны два сообщения: «абра ка дабра» и «завтра среда». Надо определить, в каком из них информации больше.

(В первом сообщении — 13 байт, во втором — 12 байт, поэтому ученики могут ответить, что в первом.)

Учитель . Сравните количество информации в двух словах: «яблоко» и «apple».

По количеству символов в первом слове больше информации, но многие ученики могут заметить, что смысл обоих слов одинаков.

Можно попросить трех учеников задать учителю один и тот же вопрос: «Сегодня у вас есть урок информатики?» Первому ученику учитель отвечает «Да», второму — «Yes», а третьему просто кивает головой.

Полезно изобразить ответы на доске:

После этого следует спросить учеников, получил ли каждый из них информацию. Ученики ответят, что да, получили. Учитель: «Сколько информации вы получили? Одинаковое ли количество в каждом случае?» После множества высказанных версий чаще всего приходим к выводу, что количество символов в ответах разное, но содержание ответов одинаково. Возникает проблема: как измерить полученное количество информации?

Учитель . Давайте вспомним, для чего нам нужна информация? (Для принятия решения.) Какое из сообщений — — «абра ка дабра» и «завтра среда» — больше повлияет на принятие вами решения? (Большинство учащихся, как правило, отвечает, что второе.) Значит ли это, что во втором сообщении информации больше? От чего зависит объем информации? Итак, если учитывать смысл сообщения, то информации больше во втором сообщении, если учитывать только количество знаков, то в первом.

2. Изучение нового материала

Учитель . Мы уже умеем вычислять количество информации в специальных единицах измерения с технической точки зрения, как в ЭВМ. Давайте научимся измерять количество информации с точки зрения содержания информации. Итак, тема сегодняшнего урока — «Содержательный подход к измерению информации»

В истории информатики имя американского ученого Клода Шеннона занимает одно из самых главных мест. Он является основоположником математической теории информации, появившейся в 30-х гг. XXв.

Историческая справка . Шеннон (Shannon) Клод Олвуд (р. 30.4.1916, Гейлорд, шт. Мичиган, США) — американский ученый и инженер, один из создателей математической теории информации, с 1956 г. — член национальной Академии наук США и Американской академии искусств и наук. Окончил Мичиганский университет (1936). В 194]—1957 гг. — сотрудник математической лаборатории компании «Белл систем». С 1957 г. —— профессор электротехники и математики Массачуеетского технологического института. Основные труды но алгебре логики, теории релейно-контактных схем, математической теории связи, информации и кибернетике. (См.: Работы по теории информации и кибернетике. М., 1963.)

Учитель . Прочитайте определение информации Клода Шеннона.

«Информация как снятая неопределенность»

Учитель . Как вы понимаете это определение? Что означает «неопределенность»? Приведите синонимы этого слова. (Неизвестность, незнание и т. д.) А что означает «снятая неопределенность»? Под «информацией» Клод Шеннон понимал не любые сведения, а лишь те, которые снимают полностью или уменьшают существующую до их получения неизвестность (неопределенность). Итак, вы сказали, что информация нужна для принятия решения. Какого решения? (Правильного, для достижения поставленной цели.) Можно ли измерить, сколько информации нужно для принятия правильного решения? Сколько нужно информации, чтобы снять неопределенность, незнание?

Я не знаю, есть ли на улице дождь, неопределенность. Я вас спрашиваю, есть ли на улице дождь. Когда я получу ответ, моя информация об окружающем мире увеличится? На сколько? Если вы ответили «да»? (Увеличилась.) Если вы ответили «нет»? (Тоже увеличилась.) На сколько? (Иногда учащиеся могут ответить, что «да>> — 2 байта, «нет» — — 3 байта, тогда учитель может привести пример английских вариантов этих слов: «yes» — 3 байта, «по» — 2 байта. Полезно обратить внимание на то, что просто кивок головы может полностью снять существующую неопределенность, а значит, содержать информацию.) Одинаковое ли количество информации в этих двух ответах?

Я подброшу монетку, и она упадет или «орлом», или «решкой». Неопределенность? Сколько информации содержит сообщение о том, какой стороной упала монетка?

Получение информации (ее увеличение) одновременно означает увеличение знания, что, в свою очередь, означает уменьшение незнания или информационней неопределенности.

Книга лежит на одной из двух полок — верхней или нижней (неопределенность). Во сколько раз уменьшится неопределенность после сообщения о том, что книга лежит на верхней полке? (Ровно в 2 раза.) Неопределенность снимается полностью? (Да.) На данный вопрос существует только два варианта ответа.

Можно ли закодировать варианты ответа двоичными цифрами и измерить количество информации? А если полок четыре? Тогда один вопрос уменьшит неопределенность, но не снимет ее полностью.

Учитель. Загадайте любое целое число от 1 до 32. (Кто-то из ребят пишет число на доске, учитель может выйти из класса или стоять спиной к доске, лицом к детям.) Считайте, сколько вопросов я задам для отгадывания числа. Ответ на мой вопрос должен быть «да» или «пет».

Для отгадывания достаточно 5 вопросов.

Можно повторить игру еще раз или пригласить вызвавшегося отгадывать ученика.

Учитель . Каждый ответ на вопрос снимает (уменьшает) неопределенность в 2 раза. После 5 вопросов можно отгадать задуманное число — неопределенности не осталось. Сколько всего чисел? (32.) Нет ли какой-нибудь связи между числами 2, 5, 32? (32 = 2 5 .) В простейшем случае выбор одного из двух сообщений («да» или «нет», 1 или 0) принимают за единицу измерения информации — бит, двоичную цифру. То есть мы используем двоичный алфавит для кодирования информации. Итак, сколько информации содержит ответ на вопрос, предполагающий два варианта ответа — «да» и «нет»? (1 бит.) Попробуйте сделать вывод, от чего зависит количество информации в сообщении. Молено сказать, что количество бит информации в сообщении о событии совпадает с количеством вопросов, которые необходимо задать, чтобы полностью сиять неопределенность.

Ученики записывают вывод в тетрадь:

2′ — N, N— количество возможных вариантов исхода некоторого события,

i — количество бит в сообщении о событии.

Если было загадано число от 1 до 16, сколько вопросов надо задать, чтобы его угадать? (4.)

Сколько информации будет получено? (4 бита.)

Проводится лотерея «5 из 64». Первым вытащили шар с номером 8. Сколько информации в этом сообщении? (6 бит.)

Объявляют оценки за контрольную работу. Сколько информации содержит сообщение об оценке? (Если возможных вариантов оценок — пять («5», «4», «3», «2», «1»), то 3 бита; если вариантов оценок — четыре («5», «4», «3», «2»), то 2 бита.)

Работа по карточкам в парах (группах). Вариант 1.

1. «На улице идет дождь?» — спросили вы. «Нет», —- ответили вам. Сколько бит информации вы получили?

2. Столицу Англии Лондон называют туманным Альбионом, так как, по статистике, из 365 дней в году 320 дней там идет дождь. Сравните количество информации в сообщениях: «На улице идет дождь» и «На улице дождя нет» с точки зрения жителей Лондона.

ПОМНИТЕ, ЧТО ИНФОРМАЦИЯ НАМ НУЖНА ДЛЯ ПРИНЯТИЯ РЕШЕНИЯ.

1. «На улице идет дождь?» — спросили вы. «Да», — ответили вам. Сколько

бит информации вы получили?

2. В южноамериканской стране Перу есть горные районы, в которых дождя не

было около 300 лет! Сравните количество информации в сообщениях: «На улице

идет дождь» и «На улице дождя нет» с точки зрения жителей этих районов.

ПОМНИТЕ, ЧТО ИНФОРМАЦИЯ НАМ НУЖНА ДЛЯ ПРИНЯТИЯ РЕШЕНИЯ.

1. «Ты меня любишь?» — спросил влюбленный юноша девушку. «Да», — ответила та. Сколько бит информации содержит ее ответ?

2. Влюбленный юноша 100 раз спрашивал девушку и каждый раз получал один

и тот же ответ — «Да». Спросив в 101-й раз «Ты меня любишь?», он вдруг получил

ответ «Нет». Сколько бит информации содержит этот ответ?

ПОМНИТЕ, ЧТО ИНФОРМАЦИЯ НАМ НУЖНА ДЛЯ ПРИНЯТИЯ РЕШЕНИЯ.

На обсуждение и решение задач в группах отводится 2—3 минуты. Затем представители групп выступают, рассказывая о решении задач.

Учитель. Все рассмотренные нами ранее примеры имеют равновероятные исходы: монета может упасть только «орлом» или «решкой» — два равновероятных исхода; задуманным может оказаться любое из 32 чисел — 32 вероятных исхода. Но всегда ли вероятность событий бывает равной? Не всегда. Попробуйте сделать вывод, от чего еще зависит количество информации в сообщении.

Таким образом, количество информации зависит не только от возможных вариантов исхода события, но и от вероятности получения ответа. Причем чем больше вероятность события, тем меньшее количество информации в сообщении о таком событии. Вероятность — ожидаемость события. Она измеряется в долях (от 0 до 1) или в процентах.

Можно сделать вывод: количество информации зависит от вероятности события. (Учащиеся записывают вывод в тетради.)

Вернемся к нашей задаче об оценках. Одинаково ли количество информации в сообщении о разных оценках? Достигли мы цели нашего урока?

Известно, что Иванов живет на улице Весенней, но неизвестно, в каком доме, — неопределенность. На сколько уменьшилась неопределенность при получении сообщения, что Иванов живет на четной стороне улицы? [Неопределенность уменьшилась, но полностью не снялась.) Нельзя сказать, что неопределенность уменьшилась вдвое, т. е. мы получили 1 бит информации. Например, на нечетной стороне улицы может быть пять домов, а на четной — всего один.

Ответы. 1 — а, 2 — 1 бит, 3 —- 4 вопроса, 4 — 32 дома, 5 — б, 6 — в, 7 — 4 бита,

Далее проводится коррекция по результатам проверочного теста, решаются задачи, вызвавшие наибольшее затруднение.

Выбранный для просмотра документ Презентация — содержательный подход.pptx

Описание презентации по отдельным слайдам:

Содержательный подход к измерению информации

абра как дабра завтра среда где Больше информации?

где Больше информации? яблоко apple

Неизмеримость информации в быту Вероятностный или содержательный подход Алфавитный подход Три подхода к измерению информации:

Клод Шеннон (1916 – 2001)

«Информация есть снятая неопределенность» Клод Шеннон

Сообщение, уменьшающее неопределённость знаний о некотором событии в 2 раза, несёт 1 бит информации

2 вариант возможных событий: Либо выпадает «Орел», либо — «Решка».

Кол-во битов 0 1 2 3 4 5 6 7 8 9 10 Кол-во событий 1 2 4 8 16 32 64 128 256 512 1024

Решение задач 1.Сколько бит информации несёт сообщение о том, что из колоды в 32 карты достали даму пик.

Решение задач 2. Сообщение о том, что Петя живёт во втором подъезде, несёт 3 бита информации. Сколько подъездов в доме?

Решение задач В коробке лежат 64 фломастера. Все фломастеры разных цветов. Какое количество информации содержит Сообщение о том, что из неё достали красный фломастер?

Решение задач Имеется 2 текста на разных языках. Первый текст имеет 32-символьный алфавит и содержит 200 символов. Второй 16-символьный алфавит и содержит 250 символов. Какой из текстов Содержит больше количество информации и на сколько?

ключ к тесту 1. А 2. 1 БИТ 3. 4 ВОПРОСА 4. 32 ДОМА 5. Б 6. В 7. 4 БИТА 8. Б 9. В

Выбранный для просмотра документ Тест.docx

Тест «Содержательный подход к информации»

1. Что из нижеперечисленного НЕ является информацией с точки зрения теории информации Шеннона?

б) Сегодня на улице 10 градусов мороза.

в) Хранение, обработка и передача — основные информационные процессы.

д) Лед — твердое состояние воды.

2. «Вы выходите на следующей остановке?» — спросили человека в автобусе. «Нет», — ответил он. Сколько бит содержит его ответ?

3. Сколько вопросов надо задать, чтобы отгадать задуманное целое число от 1 до 16?

4. Сообщение «Алиса живет в доме № 23 на улице Вишневая» содержит 5 бит информации. Сколько всего домов на улице?

5. Сколько информации содержит красный сигнал светофора?

6.Во время игры в кости на игральном кубике выпало число 1. Сколько информации содержит это сообщение?

7. Сколько бит информации получит второй игрок после первого хода первого игрока в игре «Крестики-нолики» на иоле размером 4 х 4?

8. Проводятся две лотереи — «4 из 32» и «5 из 64». Сообщение о результатах какой лотереи несет больше информации?

9.Как называют начинающего пользователя ЭВМ?

Тест «Содержательный подход к информации»

1. Что из нижеперечисленного НЕ является информацией с точки зрения теории информации Шеннона?

б) Сегодня на улице 10 градусов мороза.

в) Хранение, обработка и передача — основные информационные процессы.

д) Лед — твердое состояние воды.

2. «Вы выходите на следующей остановке?» — спросили человека в автобусе. «Нет», — ответил он. Сколько бит содержит его ответ?

3. Сколько вопросов надо задать, чтобы отгадать задуманное целое число от 1 до 16?

4. Сообщение «Алиса живет в доме № 23 на улице Вишневая» содержит 5 бит информации. Сколько всего домов на улице?

5. Сколько информации содержит красный сигнал светофора?

6.Во время игры в кости на игральном кубике выпало число 1. Сколько информации содержит это сообщение?

7. Сколько бит информации получит второй игрок после первого хода первого игрока в игре «Крестики-нолики» на иоле размером 4 х 4?

8. Проводятся две лотереи — «4 из 32» и «5 из 64». Сообщение о результатах какой лотереи несет больше информации?

9.Как называют начинающего пользователя ЭВМ?

Содержание архива: конспект урока, презентация, раздаточный материал(тест).

УРОК НА ТЕМУ

«СОДЕРЖАТЕЛЬНЫЙ ПОДХОД К ИЗМЕРЕНИЮ ИНФОРМАЦИИ»

Тема урока: Содержательный подход к измерению информации (теория информации Шеннона).

Цель урока: приобретение обучающимися теоретических знаний и практических навыков по измерению количество информации с точки зрения содержательного подхода.

ХОД УРОКА

1. Актуализация опорных знаний

Проводится фронтальный опрос, вопросы по одному выводятся на экран (см. презентацию), ответы учащихся тезисно записываются на доске.

Учитель. Ребята, давайте сегодня поговорим об измерении информации. Но сначала вспомним, что вы уже знаете о науке информатике.

Что изучает информатика? (Проблемы обработки, хранения и передачи информации.)

Что является предметом изучения информатики? (Информация.)

Что мы уже знаем об информации и что умеем делать с информацией? (Знаем, что такое информация, виды информации, свойства информации; умеем кодировать информацию, измерять информацию.)

Какую информацию мы умеем измерять? (Текстовую, графическую.)

В каких единицах измеряется информация? (Бит, байт, килобит, килобайт и т. д.)

Что означают эти единицы измерения? (Бит — один двоичный знак, 1 байт = 8 бит; сигнал ЭВМ: есть — 1, нет — 0.)

От чего зависит количество информации? (Количество текстовой информации зависит от количества символов, графической — от количества точек и количества цветов.)

Разминка на измерение информации.

На доске записаны два сообщения: «абра ка дабра» и «завтра среда». Надо определить, в каком из них информации больше.

(В первом сообщении — 13 байт, во втором — 12 байт, поэтому ученики могут ответить, что в первом.)

Учитель. Сравните количество информации в двух словах: «яблоко» и «apple».

По количеству символов в первом слове больше информации, но многие ученики могут заметить, что смысл обоих слов одинаков.

Можно попросить трех учеников задать учителю один и тот же вопрос: «Сегодня у вас есть урок информатики?» Первому ученику учитель отвечает «Да», второму — «Yes», а третьему просто кивает головой.

Полезно изобразить ответы на доске:

После этого следует спросить учеников, получил ли каждый из них информацию. Ученики ответят, что да, получили. Учитель: «Сколько информации вы получили? Одинаковое ли количество в каждом случае?» После множества высказанных версий чаще всего приходим к выводу, что количество символов в ответах разное, но содержание ответов одинаково. Возникает проблема: как измерить полученное количество информации?

Учитель. Давайте вспомним, для чего нам нужна информация? (Для принятия решения.) Какое из сообщений — — «абра ка дабра» и «завтра среда» — больше повлияет на принятие вами решения? (Большинство учащихся, как правило, отвечает, что второе.) Значит ли это, что во втором сообщении информации больше? От чего зависит объем информации? Итак, если учитывать смысл сообщения, то информации больше во втором сообщении, если учитывать только количество знаков, то в первом.

2. Изучение нового материала

Учитель. Мы уже умеем вычислять количество информации в специальных единицах измерения с технической точки зрения, как в ЭВМ. Давайте научимся измерять количество информации с точки зрения содержания информации. Итак, тема сегодняшнего урока — «Содержательный подход к измерению информации»

В истории информатики имя американского ученого Клода Шеннона занимает одно из самых главных мест. Он является основоположником математической теории информации, появившейся в 30-х гг. XXв.

Историческая справка. Шеннон (Shannon) Клод Олвуд (р. 30.4.1916, Гейлорд, шт. Мичиган, США) — американский ученый и инженер, один из создателей математической теории информации, с 1956 г. — член национальной Академии наук США и Американской академии искусств и наук. Окончил Мичиганский университет (1936). В 194]—1957 гг. — сотрудник математической лаборатории компании «Белл систем». С 1957 г. —— профессор электротехники и математики Массачуеетского технологического института. Основные труды но алгебре логики, теории релейно-контактных схем, математической теории связи, информации и кибернетике. (См.: Работы по теории информации и кибернетике. М., 1963.)

Учитель. Прочитайте определение информации Клода Шеннона.

«Информация как снятая неопределенность»

Учитель. Как вы понимаете это определение? Что означает «неопределенность»? Приведите синонимы этого слова. (Неизвестность, незнание и т. д.) А что означает «снятая неопределенность»? Под «информацией» Клод Шеннон понимал не любые сведения, а лишь те, которые снимают полностью или уменьшают существующую до их получения неизвестность (неопределенность). Итак, вы сказали, что информация нужна для принятия решения. Какого решения? (Правильного, для достижения поставленной цели.) Можно ли измерить, сколько информации нужно для принятия правильного решения? Сколько нужно информации, чтобы снять неопределенность, незнание?

Пример 1.

Я не знаю, есть ли на улице дождь, неопределенность. Я вас спрашиваю, есть ли на улице дождь. Когда я получу ответ, моя информация об окружающем мире увеличится? На сколько? Если вы ответили «да»? (Увеличилась.) Если вы ответили «нет»? (Тоже увеличилась.) На сколько? (Иногда учащиеся могут ответить, что «да>> — 2 байта, «нет» — — 3 байта, тогда учитель может привести пример английских вариантов этих слов: «yes» — 3 байта, «по» — 2 байта. Полезно обратить внимание на то, что просто кивок головы может полностью снять существующую неопределенность, а значит, содержать информацию.) Одинаковое ли количество информации в этих двух ответах?

Есть дождь?

Да Нет

Пример 2.

Я подброшу монетку, и она упадет или «орлом», или «решкой». Неопределенность? Сколько информации содержит сообщение о том, какой стороной упала монетка?

Орел?

Да Нет

Получение информации (ее увеличение) одновременно означает увеличение знания, что, в свою очередь, означает уменьшение незнания или информационней неопределенности.

Пример 3.

Книга лежит на одной из двух полок — верхней или нижней (неопределенность). Во сколько раз уменьшится неопределенность после сообщения о том, что книга лежит на верхней полке? (Ровно в 2 раза.) Неопределенность снимается полностью?(Да.) На данный вопрос существует только два варианта ответа.

Верхняя полка?

Да Нет

Можно ли закодировать варианты ответа двоичными цифрами и измерить количество информации? А если полок четыре? Тогда один вопрос уменьшит неопределенность, но не снимет ее полностью.

Игра-пример.

Учитель. Загадайте любое целое число от 1 до 32. (Кто-то из ребят пишет число на доске, учитель может выйти из класса или стоять спиной к доске, лицом к детям.) Считайте, сколько вопросов я задам для отгадывания числа. Ответ на мой вопрос должен быть «да» или «пет».

Для отгадывания достаточно 5 вопросов.

Можно повторить игру еще раз или пригласить вызвавшегося отгадывать ученика.

Учитель. Каждый ответ на вопрос снимает (уменьшает) неопределенность в 2 раза. После 5 вопросов можно отгадать задуманное число — неопределенности не осталось. Сколько всего чисел? (32.) Нет ли какой-нибудь связи между числами 2, 5, 32? (32 = 2 5 .) В простейшем случае выбор одного из двух сообщений («да» или «нет», 1 или 0) принимают за единицу измерения информации — бит, двоичную цифру. То есть мы используем двоичный алфавит для кодирования информации. Итак, сколько информации содержит ответ на вопрос, предполагающий два варианта ответа — «да» и «нет»? (1 бит.) Попробуйте сделать вывод, от чего зависит количество информации в сообщении. Молено сказать, что количество бит информации в сообщении о событии совпадает с количеством вопросов, которые необходимо задать, чтобы полностью сиять неопределенность.

Ученики записывают вывод в тетрадь:

2′ — N, N— количество возможных вариантов исхода некоторого события,

i— количество бит в сообщении о событии.

Задача 1.

Если было загадано число от 1 до 16, сколько вопросов надо задать, чтобы его угадать? (4.)

Сколько информации будет получено? (4 бита.)

Задача 2.

Проводится лотерея «5 из 64». Первым вытащили шар с номером 8. Сколько информации в этом сообщении? (6 бит.)

Задача 3.

Объявляют оценки за контрольную работу. Сколько информации содержит сообщение об оценке? (Если возможных вариантов оценок — пять («5», «4», «3», «2», «1»), то 3 бита; если вариантов оценок — четыре («5», «4», «3», «2»), то 2 бита.)

Работа по карточкам в парах (группах). Вариант 1.

1. «На улице идет дождь?» — спросили вы. «Нет», —- ответили вам. Сколько бит информации вы получили?

2. Столицу Англии Лондон называют туманным Альбионом, так как, по статистике, из 365 дней в году 320 дней там идет дождь. Сравните количество информации в сообщениях: «На улице идет дождь» и «На улице дождя нет» с точки зрения жителей Лондона.

ПОМНИТЕ, ЧТО ИНФОРМАЦИЯ НАМ НУЖНА ДЛЯ ПРИНЯТИЯ РЕШЕНИЯ.

1. «На улице идет дождь?» — спросили вы. «Да», — ответили вам. Сколько

бит информации вы получили?

2. В южноамериканской стране Перу есть горные районы, в которых дождя не

было около 300 лет! Сравните количество информации в сообщениях: «На улице

идет дождь» и «На улице дождя нет» с точки зрения жителей этих районов.

ПОМНИТЕ, ЧТО ИНФОРМАЦИЯ НАМ НУЖНА ДЛЯ ПРИНЯТИЯ РЕШЕНИЯ.

Вариант 3.

1. «Ты меня любишь?» — спросил влюбленный юноша девушку. «Да», — ответила та. Сколько бит информации содержит ее ответ?

2. Влюбленный юноша 100 раз спрашивал девушку и каждый раз получал один

и тот же ответ — «Да». Спросив в 101-й раз «Ты меня любишь?», он вдруг получил

ответ «Нет». Сколько бит информации содержит этот ответ?

ПОМНИТЕ, ЧТО ИНФОРМАЦИЯ НАМ НУЖНА ДЛЯ ПРИНЯТИЯ РЕШЕНИЯ.

На обсуждение и решение задач в группах отводится 2—3 минуты. Затем представители групп выступают, рассказывая о решении задач.

Учитель. Все рассмотренные нами ранее примеры имеют равновероятные исходы: монета может упасть только «орлом» или «решкой» — два равновероятных исхода; задуманным может оказаться любое из 32 чисел — 32 вероятных исхода. Но всегда ли вероятность событий бывает равной? Не всегда. Попробуйте сделать вывод, от чего еще зависит количество информации в сообщении.

Таким образом, количество информации зависит не только от возможных вариантов исхода события, но и от вероятности получения ответа. Причем чем больше вероятность события, тем меньшее количество информации в сообщении о таком событии. Вероятность — ожидаемость события. Она измеряется в долях (от 0 до 1) или в процентах.

Можно сделать вывод: количество информации зависит от вероятности события. (Учащиеся записывают вывод в тетради.)

Вернемся к нашей задаче об оценках. Одинаково ли количество информации в сообщении о разных оценках? Достигли мы цели нашего урока?

Задача 4.

Известно, что Иванов живет на улице Весенней, но неизвестно, в каком доме, — неопределенность. На сколько уменьшилась неопределенность при получении сообщения, что Иванов живет на четной стороне улицы? [Неопределенность уменьшилась, но полностью не снялась.) Нельзя сказать, что неопределенность уменьшилась вдвое, т. е. мы получили 1 бит информации. Например, на нечетной стороне улицы может быть пять домов, а на четной — всего один.

3. Тестирование

Ответы. 1 — а, 2 — 1 бит, 3 —- 4 вопроса, 4 — 32 дома, 5 — б, 6 — в, 7 — 4 бита,

Далее проводится коррекция по результатам проверочного теста, решаются задачи, вызвавшие наибольшее затруднение.

- http://xn----7sbbfb7a7aej.xn--p1ai/informatika_kabinet/inf_prozes/inf_prozes_06.html

- http://www.sites.google.com/site/izmerinf/home/soderzatelnyj-podhod

- http://spravochnick.ru/informatika/kodirovanie_informacii/soderzhatelnyy_podhod_k_ocenke_kolichestva_informacii/

- http://studfiles.net/preview/1743337/page:2/

- http://infourok.ru/soderzhatelniy-podhod-k-izmereniyu-informacii-937267.html