K

Это незавершённая статья из области эвентологии и её применений, редактируемая при участии Мастера

Энтропи́я в теории информации — мера хаотичности информации, неопределённость появления какого-либо символа первичного алфавита. При отсутствии информационных потерь численно равна количеству информации на символ передаваемого сообщения.

Так, возьмём, например, последовательность символов, составляющих какое-либо предложение на русском языке. Каждый символ появляется с разной частотой, следовательно, неопределённость появления для некоторых символов больше, чем для других. Если же учесть, что некоторые сочетания символов встречаются очень редко, то неопределённость ещё более уменьшается (в этом случае говорят об энтропии n-ого порядка, см. Условная энтропия).

Концепции информации и энтропии имеют глубокие связи друг с другом, но, несмотря на это, разработка теорий в статистической механике и теории информации заняла много лет, чтобы сделать их соответствующими друг другу. Ср. тж. Термодинамическая энтропия

Формальные определения [ править ]

Энтропия независимых случайных событий x с n возможными состояниями (от 1 до n) рассчитывается по формуле:

Эта величина также называется средней энтропией сообщения. Величина называется частной энтропией, характеризующей только i-e состояние.

Таким образом, энтропия события x является суммой с противоположным знаком всех произведений относительных частот появления события i, умноженных на их же двоичные логарифмы (основание 2 выбрано только для удобства работы с информацией, представленной в двоичной форме). Это определение для дискретных случайных событий можно расширить для функции распределения вероятностей.

Шеннон вывел это определение энтропии из следующих предположений:

- мера должна быть непрерывной; т. е. изменение значения величины вероятности на малую величину должно вызывать малое результирующее изменение энтропии;

- в случае, когда все варианты (буквы в приведенном примере) равновероятны, увеличение количества вариантов (букв) должно всегда увеличивать полную энтропию;

- должна быть возможность сделать выбор (в нашем примере букв) в два шага, в которых энтропия конечного результата должна будет являтся суммой энтропий промежуточных результатов.

Шеннон показал, что любое определение энтропии, удовлетворяющее этим предположениям, должно быть в форме:

где K — константа (и в действительности нужна только для выбора единиц измерения).

Шеннон определил, что измерение энтропии (H = − p1 log2p1 − … − pn log2pn), применяемое к источнику информации, может определить требования к минимальной пропускной способности канала, требуемой для надежной передачи информации в виде закодированных двоичных чисел. Для вывода формулы Шеннона необходимо вычислить математическое ожидания «количества информации», содержащегося в цифре из источника информации. Мера энтропии Шеннона выражает неуверенность реализации случайной переменной. Таким образом, энтропия является разницей между информацией, содержащейся в сообщении, и той частью информации, которая точно известна (или хорошо предсказуема) в сообщении. Примером этого является избыточность языка — имеются явные статистические закономерности в появлении букв, пар последовательных букв, троек и т.д. См. Цепи Маркова.

В общем случае b-арная энтропия (где b равно 2,3. ) источника = (S,P) с исходным алфавитом S = a1, …, an> и дискретным распределением вероятности P = p1, …, pn> где pi является вероятностью ai (pi = p(ai)) определяется формулой:

Определение энтропии Шеннона очень связано с понятием термодинамической энтропии. Больцман и Гиббс проделали большую работу по статистической термодинамике, которая способствовала принятию слова «энтропия» в информационную теорию. Существует связь между понятиями энтропии в термодинамике и теории информации. Например, демон Максвелла также противопоставляет термодинамическую энтропию информации, и получение какого-либо количества информации равно потерянной энтропии.

Условная энтропия [ править ]

Если следование символов алфавита не независимо (например, во французском языке после буквы «q» почти всегда следует «u», а после слова «передовик» в советских газетах обычно следовало слово «производства» или «труда»), количество информации, которую несёт последовательность таких символов (а следовательно и энтропия) очевидно меньше. Для учёта таких фактов используется условная энтропия.

Условной энтропией первого порядка (аналогично для Марковской модели первого порядка) называется энтропия для алфавита, где известны вероятности появления одной буквы после другой (т.е. вероятности двухбуквенных сочетаний):

где — это состояние, зависящее от предшествующего символа, и — это вероятность , при условии, что был предыдущим символом.

Так, для русского алфавита без буквы «ё» .

Через частную и общую условные энтропии полностью описываются информационные потери при передаче данных в канале с помехами. Для этого применяются т.н. канальные матрицы. Так, для описания потерь со стороны источника (т.е. известен посланный сигнал), рассматривают условную вероятность получения приёмником символа при условии, что был отправлен символ . При этом канальная матрица имеет следующий вид:

| . | . | |||||

|---|---|---|---|---|---|---|

| . | . | |||||

| . | . | |||||

| . | . | . | . | . | . | . |

| . | . | |||||

| . | . | . | . | . | . | . |

| . | . |

Очевидно, вероятности, расположенные по диагонали описывают вероятность правильного приёма, а сумма всех элементов столбца даст вероятность появления соответствующего символа на стороне приёмника — . Потери, приходящиеся на предаваемый сигнал , описываются через частную условную энтропию:

Для вычисления потерь при передаче всех сигналов используется общая условная энтропия:

означает энтропию со стороны источника, аналогично рассматривается — энтропия со стороны приёмника: вместо всюду указывается (суммируя элементы строки можно получить , а элементы диагонали означают вероятность того, что был отправлен именно тот символ, который получен, т.е. вероятность правильной передачи).

Взаимная энтропия [ править ]

Взаимная энтропия, или энтропия объединения, предназначена для рассчёта энтропии взаимосвязанных систем (энтропии совместного появления статистически зависимых сообщений) и обозначается , где , как всегда, характеризует передатчик, а — приёмник.

Взаимосязь переданных и полученных сигналов описывается вероятностями совместных событий , и для полного описания характеристик канала требуется только одна матрица:

| … | … | ||||

| … | … | ||||

| … | … | … | … | … | … |

| … | … | ||||

| … | … | … | … | … | … |

| … | … |

Для более общего случая, когда описывается не канал, а просто взаимодействующие системы, матрица необязательно должна быть квадратной. Очевидно, сумма всех элементов столбца с номером даст , сумма строки с номером есть , а сумма всех элементов матрицы равна 1. Совместная вероятность событий и вычисляется как произведение исходной и условной вероятности,

Условные вероятности производятся по формуле Байеса. Таким образом имеются все данные для вычисления энтропий источника и приёмника:

Взаимная энтропия вычисляется последовательным суммированием по строкам (или по столбцам) всех вероятностей матрицы, умноженных на их логарифм:

Единица измерения — бит/два символа, это объясняется тем, что взаимная энтропия описывает неопределённость на пару символов — отправленного и полученного. Путём несложных преобразований также получаем

Взаимная энтропия обладает свойством информационной полноты — из неё можно получить все рассматриваемые величины.

Свойства [ править ]

Важно помнить, что энтропия является количеством, определённым в контексте вероятностной модели для источника данных. Например, кидание монеты имеет энтропию бита на одно кидание (при условии его независимости). У источника, который генерирует строку, состоящую только из букв «А», энтропия равна нулю: . Так, к примеру, опытным путём можно установить, что энтропия английского текста равна 1,5 бит на символ, что конечно будет варьироваться для разных текстов. Степень энтропии источника данных означает среднее число битов на элемент данных, требуемых для её зашифровки без потери информации, при оптимальном кодировании.

- Некоторые биты данных могут не нести информации. Например, структуры данных часто хранят избыточную информацию, или имеют идентичные секции независимо от информации в структуре данных.

- Количество энтропии не всегда выражается целым числом бит.

Альтернативное определение [ править ]

Другим способом определения функции энтропии H является доказательство, что H однозначно определена (как указано ранее), если и только если H удовлетворяет пунктам 1)—3):

1) H(p1, …, pn) определена и непрерывна для всех p1, …, pn, где pi [0,1] для всех i = 1, …, n и p1 + … + pn = 1. (Заметьте, что эта функция зависит только от распределения вероятностей, а не от алфавита.)

2) Для целых положительных n, должно выполняться следующее неравенство:

3) Для целых положительных bi, где b1 + … + bn = n, должно выполняться равенство:

Эффективность [ править ]

Исходный алфавит, встречающийся на практике, имеет вероятностное распределение, которое далеко от оптимального. Если исходный алфавит имел n символов, тогда он может может быть сравнён с «оптимизированным алфавитом», вероятностное распределение которого однородно. Соотношение энтропии исходного и оптимизированного алфавита — это эффективность исходного алфавита, которая может быть выражена в процентах.

Из этого следует, что эффективность исходного алфавита с n символами может быть определена просто как равная его n-арной энтропии.

Энтропия ограничивает максимально возможное сжатие без потерь (или почти без потерь), которое может быть реализовано при использовании теоретически — типичного набора или, на практике, — кодирования Хаффмана, кодирования Лемпеля-Зива или арифметического кодирования.

История [ править ]

В 1948 году, исследуя проблему рациональной передачи информации через зашумленный коммуникационный канал, Клод Шеннон предложил революционный вероятностный подход к пониманию коммуникаций и создал первую, истинно математическую, теорию энтропии. Его сенсационные идеи быстро послужили основой разработки двух основных направлений: теории информации, которая использует понятие вероятности и эргодическую теорию для изучения статистических характеристик данных и коммуникационных систем, и теории кодирования, в которой используются главным образом алгебраические и геометрические инструменты для разработки эффективных шифров.

Понятие энтропии, как меры случайности, введено Шенноном в его статье «A Mathematical Theory of Communication», опубликованной в двух частях в Bell System Technical Journal в 1948 году.

- Внутренняя энергия

- Энтропия

- Энтальпия

- Свободная энергия Гельмгольца

- Энергия Гиббса

- Большой термодинамический потенциал (Ω)

- Начала

- Уравнение состояния

- Термодинамические величины

- Термодинамические потенциалы

- Термодинамические циклы

- Фазовый переход

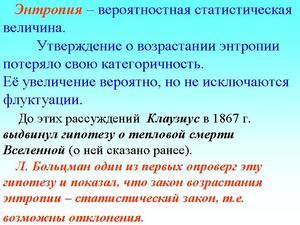

Энтропи́я (от др.-греч. ἐν — «в» и τροπία — «поворот», «превращение») — широко используемый в естественных и точных науках термин. Впервые введён в рамках термодинамики как функция состояния термодинамической системы, определяющая меру необратимого рассеивания энергии. В статистической физике энтропия характеризует вероятность осуществления какого-либо макроскопического состояния. Кроме физики, термин широко употребляется в математике: теории информации и математической статистике. Для энтропии (чаще в математике) встречается также название шенноновская информация или количество информации по Шеннону [1] .

Энтропия может интерпретироваться как мера неопределённости (неупорядоченности) некоторой системы, например, какого-либо опыта (испытания), который может иметь разные исходы, а значит, и количество информации [2] [3] . Таким образом, другой интерпретацией энтропии является информационная ёмкость системы. С данной интерпретацией связан тот факт, что создатель понятия энтропии в теории информации (Клод Шеннон) сначала хотел назвать эту величину информацией.

Понятие информационной энтропии применяется как в теории информации и математической статистике, так и в статистической физике (энтропия Гиббса и её упрощённый вариант — энтропия Больцмана) [4] [5] . Математический смысл информационной энтропии — это логарифм числа доступных состояний системы (основание логарифма может быть различным, но большим 1, оно определяет единицу измерения энтропии) [6] . Такая функция от числа состояний обеспечивает свойство аддитивности энтропии для независимых систем. Причём, если состояния различаются по степени доступности (то есть не равновероятны), под числом состояний системы нужно понимать их эффективное количество, которое определяется следующим образом. Пусть состояния системы равновероятны и имеют вероятность p

В случае разных вероятностей состояний p i >

H = log N ¯ = − ∑ i = 1 N p i log p i . >=-\sum _^

Подобная интерпретация справедлива и для энтропии Реньи, которая является одним из обобщений понятия информационная энтропия, но в этом случае иначе определяется эффективное количество состояний системы (можно показать, что энтропии Реньи соответствует эффективное количество состояний, определяемое как среднее степенное взвешенное с параметром q ≤ 1

Следует заметить, что интерпретация формулы Шеннона на основе взвешенного среднего не является её обоснованием. Строгий вывод этой формулы может быть получен из комбинаторных соображений с помощью асимптотической формулы Стирлинга и заключается в том, что комбинаторность распределения (то есть число способов, которыми оно может быть реализовано) после взятия логарифма и нормировки в пределе совпадает с выражением для энтропии в виде, предложенном Шенноном [8] [9] .

В широком смысле, в каком слово часто употребляется в быту, энтропия означает меру неупорядоченности или хаотичности системы: чем меньше элементы системы подчинены какому-либо порядку, тем выше энтропия.

Величина, противоположная энтропии, именуется негэнтропией или, реже, экстропией.

Содержание

Аксиоматическое определение энтропии

Выражение для информационной энтропии может быть выведено на основе некоторой системы аксиом. Одним из подходов является следующая система аксиом, известная как система аксиом Хинчина [10] .

1. Пусть некоторая система может пребывать в каждом из N

Указанный набор аксиом однозначно приводит к формуле для энтропии Шеннона.

Некоторые авторы [11] обращают внимание на неестественность последней аксиомы Хинчина. И действительно, более простым и очевидным является требование аддитивности энтропии для независимых систем. Таким образом, последняя аксиома может быть заменена следующим условием.

4′. Энтропия совокупности двух независимых систем P

Оказывается, система аксиом с пунктом 4′ приводит не только к энтропии Шеннона, но и к энтропии Реньи.

Употребление в различных дисциплинах

- Термодинамическая энтропия — термодинамическая функция, характеризующая меру необратимой диссипации энергии в ней.

- В статистической физике — характеризует вероятность осуществления некоторого макроскопического состояния системы.

- В математической статистике — мера неопределённости распределения вероятностей.

- Информационная энтропия — в теории информации мера неопределённости источника сообщений, определяемая вероятностями появления тех или иных символов при их передаче.

- Энтропия динамической системы — в теории динамических систем мера хаотичности в поведении траекторий системы.

- Дифференциальная энтропия — формальное обобщение понятия энтропии для непрерывных распределений.

- Энтропия отражения — часть информации о дискретной системе, которая не воспроизводится при отражении системы через совокупность своих частей.

- Энтропия в теории управления — мера неопределённости состояния или поведения системы в данных условиях.

В термодинамике

Понятие энтропии впервые было введено Клаузиусом в термодинамике в 1865 году для определения меры необратимого рассеивания энергии, меры отклонения реального процесса от идеального. Определённая как сумма приведённых теплот, она является функцией состояния и остаётся постоянной при замкнутых обратимых процессах, тогда как в необратимых — её изменение всегда положительно.

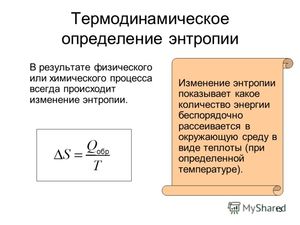

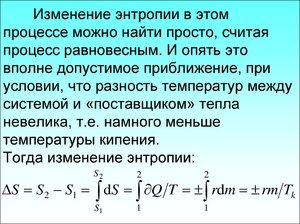

Математически энтропия определяется как функция состояния системы, определённая с точностью до произвольной постоянной. Разность энтропий в двух равновесных состояниях 1 и 2, по определению, равна приведённому количеству тепла ( δ Q / T

Так как энтропия определена с точностью до произвольной постоянной, то можно условно принять состояние 1 за начальное и положить S 1 = 0 =0>  . Тогда . Тогда

|

- http://wiki.sc/wikipedia/%D0%AD%D0%BD%D1%82%D1%80%D0%BE%D0%BF%D0%B8%D1%8F

- http://zetsila.ru/%D1%87%D1%82%D0%BE-%D1%82%D0%B0%D0%BA%D0%BE%D0%B5-%D1%8D%D0%BD%D1%82%D1%80%D0%BE%D0%BF%D0%B8%D1%8F/

- http://obrazovanie.guru/nauka/entropiya-chto-eto-takoe-obyasnenie-termina-prostymi-slovami.html

Обобщённое представление процесса с химической точки зрения: 1 — кристаллическое твёрдое вещество; 2 — жидкое состояние; 3 — газообразное состояние; 4 — возрастающая энтропия

Обобщённое представление процесса с химической точки зрения: 1 — кристаллическое твёрдое вещество; 2 — жидкое состояние; 3 — газообразное состояние; 4 — возрастающая энтропия Эффект транспорта теплообмена с передачей от теплого к холодному: Т1 — среда с более высокой температурой; Т2 — среда с более низкой температурой; Q — тепло; Т — температура

Эффект транспорта теплообмена с передачей от теплого к холодному: Т1 — среда с более высокой температурой; Т2 — среда с более низкой температурой; Q — тепло; Т — температура Диаграмма Рихарда Молье — полученная немецким тепло-техником из города Дрезден (Германия). Впервые эта диаграмма использовалась для расчётов в 1904 году

Диаграмма Рихарда Молье — полученная немецким тепло-техником из города Дрезден (Германия). Впервые эта диаграмма использовалась для расчётов в 1904 году Что такое энтропия? Этим словом можно охарактеризовать и объяснить почти все процессы в жизни человека (физические и химические процессы, а также социальные явления). Но не все люди понимают значение этого термина и уж тем более не все могут объяснить, что это слово значит. Теория сложна для восприятия, но если добавить в неё простые и понятные примеры из жизни, то разобраться с определением этого многогранного термина будет легче. Но обо всём по порядку.

Что такое энтропия? Этим словом можно охарактеризовать и объяснить почти все процессы в жизни человека (физические и химические процессы, а также социальные явления). Но не все люди понимают значение этого термина и уж тем более не все могут объяснить, что это слово значит. Теория сложна для восприятия, но если добавить в неё простые и понятные примеры из жизни, то разобраться с определением этого многогранного термина будет легче. Но обо всём по порядку. Основной постулат термодинамики о равновесии: любая изолированная термодинамическая система приходит в равновесное состояние с течением времени и не может из него выйти самопроизвольно. То есть каждая система стремится в равновесное для неё состояние. И если говорить совсем простыми словами, то такое состояние характеризуется беспорядком.

Основной постулат термодинамики о равновесии: любая изолированная термодинамическая система приходит в равновесное состояние с течением времени и не может из него выйти самопроизвольно. То есть каждая система стремится в равновесное для неё состояние. И если говорить совсем простыми словами, то такое состояние характеризуется беспорядком. В экономике используется такое понятие, как коэффициент энтропии. С помощью этого коэффициента исследуют изменение концентрации рынка и её уровень. Чем выше значение коэффициента, тем выше экономическая неопределённость и, следовательно, вероятность появления монополии снижается. Коэффициент помогает косвенно оценить выгоды, приобретённые фирмой в результате возможной монопольной деятельности или при изменении концентрации рынка.

В экономике используется такое понятие, как коэффициент энтропии. С помощью этого коэффициента исследуют изменение концентрации рынка и её уровень. Чем выше значение коэффициента, тем выше экономическая неопределённость и, следовательно, вероятность появления монополии снижается. Коэффициент помогает косвенно оценить выгоды, приобретённые фирмой в результате возможной монопольной деятельности или при изменении концентрации рынка. Здесь энтропия (информационная неопределённость) является характеристикой отклонения социума (системы) или его звеньев от принятого (эталонного) состояния, а проявляется это в снижении эффективности развития и функционирования системы, ухудшении самоорганизации. Простой пример: сотрудники фирмы так сильно загружены работой (выполнением большого количества отчётов), что не успевают заниматься своей основной деятельностью (выполнением проверок). В этом примере мерой нецелесообразного использования руководством рабочих ресурсов будет являться информационная неопределённость.

Здесь энтропия (информационная неопределённость) является характеристикой отклонения социума (системы) или его звеньев от принятого (эталонного) состояния, а проявляется это в снижении эффективности развития и функционирования системы, ухудшении самоорганизации. Простой пример: сотрудники фирмы так сильно загружены работой (выполнением большого количества отчётов), что не успевают заниматься своей основной деятельностью (выполнением проверок). В этом примере мерой нецелесообразного использования руководством рабочих ресурсов будет являться информационная неопределённость. Пример 1. Молекула находится в сосуде, который имеет левую и правую часть. Если неизвестно, в какой части сосуда находится молекула, то энтропия (S) будет определяться по формуле S = S max = k * lgW, где k -число способов реализации, W- количество частей сосуда. Информация в этом случае будет равна нулю I = I min =0. Если же точно известно, в какой части сосуда находится молекула, то S = S min =k*ln1=0, а I = I max= log 2 W. Следовательно, чем больше информации, тем ниже значение информационной неопределённости.

Пример 1. Молекула находится в сосуде, который имеет левую и правую часть. Если неизвестно, в какой части сосуда находится молекула, то энтропия (S) будет определяться по формуле S = S max = k * lgW, где k -число способов реализации, W- количество частей сосуда. Информация в этом случае будет равна нулю I = I min =0. Если же точно известно, в какой части сосуда находится молекула, то S = S min =k*ln1=0, а I = I max= log 2 W. Следовательно, чем больше информации, тем ниже значение информационной неопределённости.